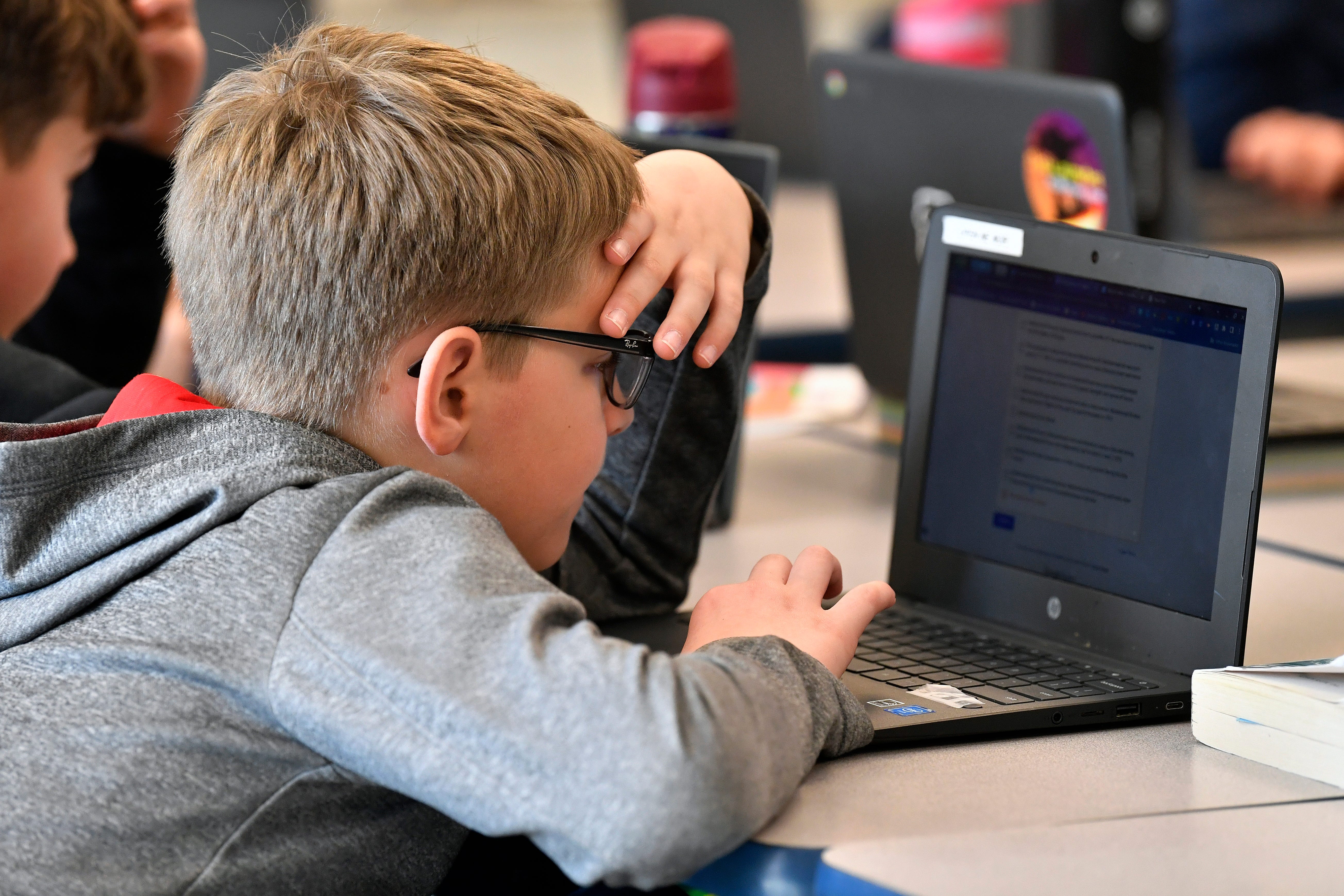

ChatGPT wurde von Fünftklässlern in Kentucky übernommen, um den Umgang mit Technologie zu lernen

ChatGPT hat Bedenken geäußert, dass Schüler einen KI-gestützten Chatbot verwenden werden, um ihre Aufsätze zu schreiben und bei ihren Hausaufgaben zu schummeln. Einige Lehrer sagen jedoch, dass es sich schnell zu einem Werkzeug entwickelt, das ihre Schüler in Zukunft brauchen werden. (14. Februar) (AP-Video: Dylan Louvain)

AP

Die erstaunliche Fähigkeit von ChatGPT, die Fragen der Menschen in sofort generierten, leicht verständlichen Antworten zu beantworten, könnte für Menschen, die medizinischen Rat suchen, ein Wendepunkt sein, aber ein neuer Artikel in einer medizinischen Fachzeitschrift besagt, dass es nicht ganz so einfach ist. So auch ChatGPT.

Peter Lee, Corporate Vice President von Microsoft, hat die letzten sechs Monate damit verbracht, mit der neuesten Version von ChatGPT zu experimentieren, einer Plattform für künstliche Intelligenz, die entwickelt wurde, um die Fragen der Benutzer mit einem Konversationston zu beantworten.

Wie andere sogenannte große Sprachparadigmen wird ChatGPT, das vom Startup OpenAI aus San Francisco entwickelt wurde, mit riesigen Datenmengen trainiert, die im Internet, in Büchern und anderen Quellen verfügbar sind. Es verwendet Algorithmen, um Wörter in einer Reihenfolge zu generieren, die auf der Häufigkeit basiert, mit der sie zusammen im Internet erscheinen. Die Bing-Suchmaschine von Microsoft verwendet jetzt ChatGPT.

Lee, ein Informatiker, der die Microsoft-Forschung auf der ganzen Welt leitet, interessiert sich besonders für das medizinische und wissenschaftliche Potenzial von ChatGPT.

bisher: ChatGPT ist bereit, medizinische Informationen zu kippen. Im Guten wie im Schlechten.

Er Ein Artikel wurde am Donnerstag im New England Journal of Medicine veröffentlicht Über die potenziellen Einsatzmöglichkeiten von ChatGPT zur Aufzeichnung medizinischer Notizen, zur Bereitstellung von Diagnosefunktionen, zur Aufklärung von Ärzten und Patienten sowie zur Analyse und Zusammenfassung von Daten. Besonders bemerkenswert, sagte er, sei die Fähigkeit der Schnittstelle, menschenähnliche empathische Antworten zu geben.

Wir haben Lee, der auch Co-Autor des kommenden Buches „The AI Revolution in Medicine: GPT-4 and Beyond“ ist, zu seiner Aufregung und Besorgnis über die neueste Version von ChatGPT, jetzt ChatGPT-4, befragt vor kurzem veröffentlicht. Wir haben die gleichen Fragen auch zu ChatGPT gestellt, aber da die Verfügbarkeit immer noch begrenzt ist, kommen die Antworten von ChatGPT-3.

Frage: Liefert ChatGPT verlässliche medizinische Informationen?

Für mich: Ich persönlich vertraue Modellen auf diesem Niveau nicht, wenn es um meine persönliche Gesundheitsberatung oder -information geht, und ich wäre besorgt, wenn Ärzte und Krankenschwestern sie verwenden würden, um medizinische Entscheidungen zu treffen.

ChatGPT: ChatGPT ist ein Sprachmodell, das mit riesigen Mengen an Textdaten, einschließlich medizinischer Informationen, trainiert wird. Es ist jedoch wichtig zu beachten, dass ChatGPT kein medizinischer Fachmann ist und seine Antworten nicht als medizinischer Rat betrachtet werden sollten.

Obwohl ChatGPT Informationen zu medizinischen Themen bereitstellen kann, ist es wichtig, diese Informationen mit einem qualifizierten Arzt zu überprüfen, bevor Sie Entscheidungen bezüglich Ihrer Gesundheit treffen. Es besteht auch das Risiko, dass ChatGPT ungenaue oder veraltete medizinische Informationen bereitstellt, die schädlich sein könnten.

Frage: Welche Arten von Fehlern macht ChatGPT und warum?

Für mich: GPT-Formulare sind im Allgemeinen sehr schlecht darin, Informationen abzurufen. Es ist fast beabsichtigt, weil GPT-Modelle ihre Trainingsdaten nicht neu kompilieren möchten. Wenn Sie ihn nach einer bestimmten Quelle fragen, wie z. B. einem Verweis auf eine Zeitung, wird er nicht in der Lage sein, die genaue Quelle zum Leben zu erwecken, also erfindet er etwas, er „halluziniert“.

ChatGPT: ChatGPT kann Fehler machen, z. B. unangemessene oder falsche Antworten geben, sich wiederholen oder Antworten produzieren, die nicht zum Kontext der Konversation passen.

Diese Fehler können auftreten, weil ChatGPT mit riesigen Mengen an Textdaten trainiert wird, einschließlich ungeprüfter und potenziell voreingenommener Informationen, die zu falschen oder veralteten Informationen führen können.

Darüber hinaus können ChatGPT-Antworten von der Qualität der empfangenen Eingaben beeinflusst werden, was zu irrelevanten oder nicht zum Thema passenden Antworten führen kann.

Frage: Inwiefern ist ChatGPT-4 besser als ChatGPT-3?

Für mich: Wir erreichen eine andere Intelligenzstufe. Die Hauptsache ist, dass Sie dieses KI-Modell haben, das viele kognitive Fähigkeiten hat, und Sie haben eine Chat-Oberfläche. Am Ende ist es wirklich natürlich, damit zu interagieren.

ChatGPT: Es ist vernünftig, Verbesserungen in Bereichen wie Umfang, Genauigkeit, Mehrsprachigkeit, Kontextverständnis und Konsistenz zu erwarten.

Frage: ChatGPT sieht manchmal wie eine echte Person aus. Hat ChatGPT eine „Theory of Mind“, also die Fähigkeit, sich die mentalen Zustände anderer Menschen vorzustellen?

Für mich: Du kannst das nicht. Es ist eine Maschine. Aber Sie können GPT-4 fragen, was der Patient (in einer bestimmten Situation) als Denken und Fühlen beschreiben würde. Er ist in der Lage, diesen Geisteszustand einzuschätzen. … Es drückt sich in einem Gefühl der Empathie für die Patienten aus.

ChatGPT: Nein, ChatGPT hat keine Theory of Mind.

ChatGPT ist ein maschinelles Lernmodell, das statistische Muster und Algorithmen verwendet, um Antworten auf Eingaben in natürlicher Sprache zu generieren. Es hat kein Bewusstsein, Emotionen oder Überzeugungen, noch hat es die Fähigkeit, die mentalen Zustände menschlicher Benutzer zu verstehen oder daraus abzuleiten.

Während ChatGPT in der Lage ist, Antworten zu generieren, die einfühlsam, ansprechend und dialogorientiert sein können, besitzt es keine Theory of Mind, die ein kritischer Aspekt der menschlichen Kognition und sozialen Interaktion ist.

Frage: Soll ChatGPT in der Medizin eingesetzt werden?

Für mich: Die Gesellschaft hat die Wahl. Wir können versuchen, diese Technologie zu verlangsamen oder abzuschalten, weil wir die Risiken nicht vollständig verstehen. Das zweite Argument ist fatalistischer und sagt: „Er ist nicht aufzuhalten. Wir können es genauso gut versuchen.“ Die dritte Option, die meiner Meinung nach die einzig vernünftige ist, aber bewusst getroffen werden sollte, besteht darin, sorgfältig darüber nachzudenken, wie wir diese Technologie in unser Leben integrieren können, damit wir Dinge erreichen können, die weder der Mensch allein noch die KI allein erreichen können. . Ich hoffe, dass die medizinische Gemeinschaft und die Öffentlichkeit die dritte Option wählen werden.

ChatGPT: ChatGPT sollte nicht nur für medizinische Beratung oder Diagnose herangezogen werden. Während ChatGPT möglicherweise Informationen zu medizinischen Themen bereitstellen kann, ist es kein medizinischer Fachmann, und seine Antworten sollten nur als Information betrachtet werden.

ChatGPT kann jedoch ein nützliches Werkzeug sein, um ein allgemeines Verständnis medizinischer Konzepte und Terminologie zu erlangen. In jedem Fall ist es wichtig, alle von ChatGPT bereitgestellten Informationen mit einem qualifizierten medizinischen Fachmann zu überprüfen, um sicherzustellen, dass sie korrekt und auf Ihre Situation anwendbar sind.

Kontaktieren Sie Karen Weintraub unter [email protected].

Die Gesundheits- und Patientensicherheitsberichterstattung von USA TODAY wird teilweise durch einen Zuschuss der Masimo Foundation for Ethics, Innovation, and Competition in Health Care ermöglicht. Die Masimo Foundation leistet keinen redaktionellen Beitrag.

„Entdecker. Entschuldigungsloser Unternehmer. Alkoholfanatiker. Zertifizierter Schriftsteller. Möchtegern-TV-Evangelist. Twitter-Fanatiker. Student. Webwissenschaftler.

More Stories

JPMorgan geht davon aus, dass die Fed ihren Leitzins in diesem Jahr um 100 Basispunkte senken wird

Die Zahl der Bitcoin-Millionäre ist um 111 % gestiegen – warum, wie und werden sie jetzt reicher?

Die Aktien des Chipriesen für künstliche Intelligenz Nvidia gaben trotz seines Rekordumsatzes von 30 Milliarden US-Dollar nach