- Das große Sprachmodell PaLM 2 von Google verwendet für das Training fast fünfmal so viele Textdaten wie sein Vorgänger LLM, wie CNBC erfahren hat.

- Bei der Ankündigung des PaLM 2 letzte Woche sagte Google, das Modell sei kleiner als das vorherige PaLM, verwende aber eine effizientere „Technologie“.

- Die mangelnde Transparenz über Trainingsdaten in KI-Modellen ist unter Forschern zu einem immer heißeren Thema geworden.

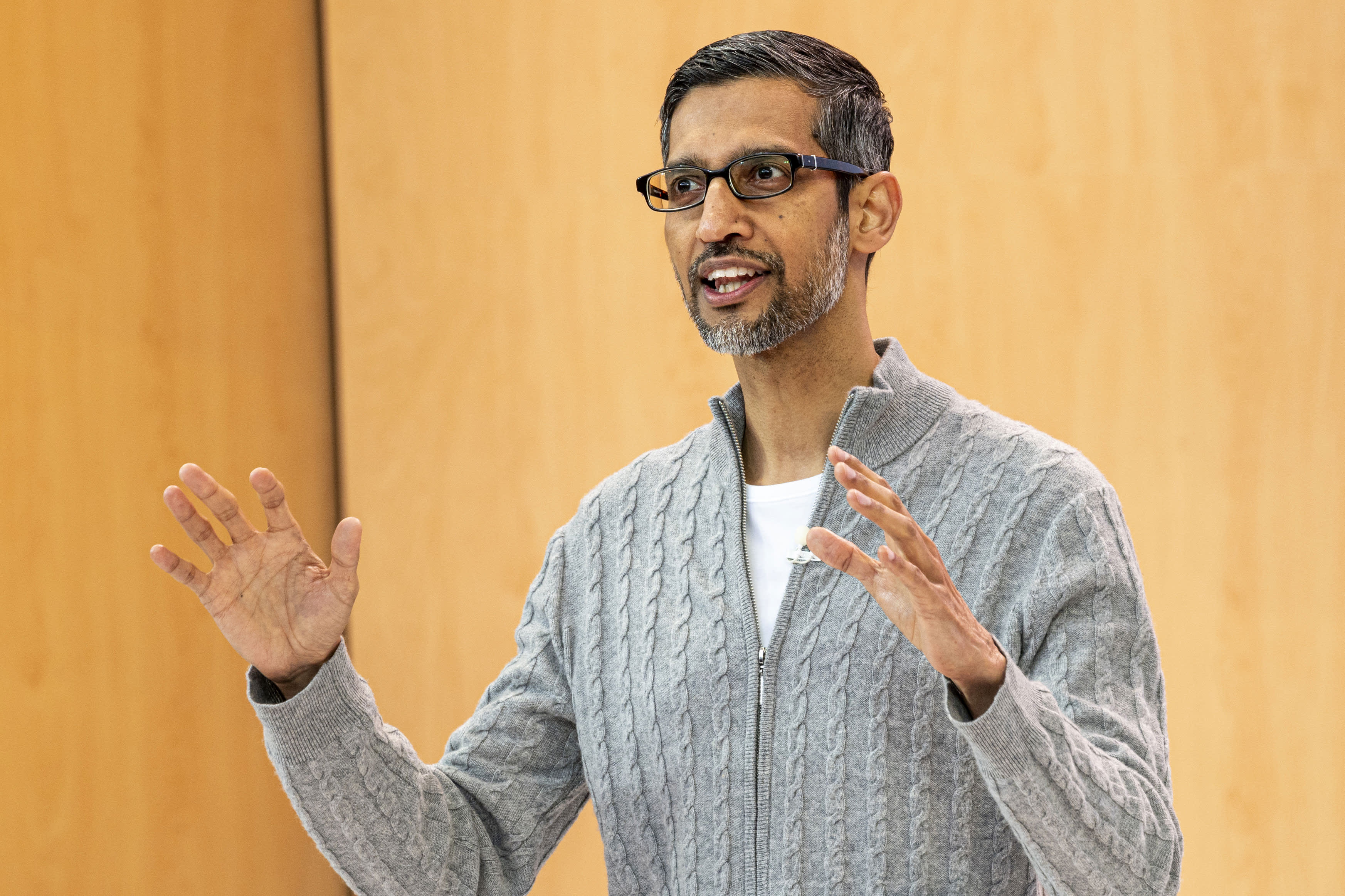

Sundar Pichai, CEO, Alphabet Inc. , während der Google I/O Developers Conference in Mountain View, Kalifornien, am Mittwoch, 10. Mai 2023.

David Paul Morris | Bloomberg | Getty Images

CNBC hat erfahren, dass das neue große Sprachmodell von Google, das das Unternehmen letzte Woche angekündigt hat, fast fünfmal so viele Trainingsdaten verwendet wie sein Vorgänger aus dem Jahr 2022, wodurch es anspruchsvollere Programmier-, Mathematik- und kreative Schreibaufgaben ausführen kann.

PaLM 2, das neue LLM-Modell (Public Use Large Language), das auf der Google I/O vorgestellt wurde, wurde laut internen Dokumenten, die CNBC eingesehen hat, auf 3,6 Billionen Token trainiert. Token, bei denen es sich um Wortfolgen handelt, sind ein wichtiger Baustein für das LLM-Training, da sie dem Modell beibringen, das nächste Wort vorherzusagen, das in einer Sequenz erscheinen wird.

Googles vorherige Version von PaLM, die für Pathways Language Model steht, wurde 2022 veröffentlicht und auf 780 Milliarden Token trainiert.

Während Google unbedingt die Leistungsfähigkeit seiner KI-Technologie und deren Integration in Suche, E-Mails, Textverarbeitung und Tabellenkalkulationen zeigen wollte, war das Unternehmen nicht bereit, den Umfang oder andere Details seiner Trainingsdaten zu veröffentlichen. OpenAI, der Innovator des von Microsoft unterstützten ChatGPT, hat auch Details der neuesten LLM-Sprache namens GPT-4 geheim gehalten.

Als Grund für die fehlende Offenlegung nennen die Unternehmen den Wettbewerbscharakter des Unternehmens. Google und OpenAI beeilen sich, Nutzer anzulocken, die möglicherweise mithilfe von Chatbots anstelle herkömmlicher Suchmaschinen nach Informationen suchen möchten.

Doch während das KI-Wettrüsten weiter tobt, fordert die Forschungsgemeinschaft mehr Transparenz.

Seit der Veröffentlichung von PaLM 2 hat Google erklärt, das neue Modell sei kleiner als frühere LLMs, was von Bedeutung ist, da es bedeutet, dass die Technologie des Unternehmens effizienter wird und gleichzeitig komplexere Aufgaben bewältigt. Laut interner Dokumentation ist PaLM 2 auf 340 Milliarden Parameter trainiert, was ein Hinweis auf die Komplexität des Modells ist. Das anfängliche PaLM wird auf 540 Milliarden Parameter trainiert.

Google hat zu dieser Geschichte nicht sofort einen Kommentar abgegeben.

Google Er sagte In einem Blogbeitrag über PaLM 2 verwendet das Modell eine „neue Technik“ namens Computational Scale Optimization. Dadurch wird das LLM „effizienter mit besserer Gesamtleistung, einschließlich schnellerer Inferenz, weniger Serviceparametern und geringeren Servicekosten“.

Bei der Ankündigung von PaLM 2 bestätigte Google frühere CNBC-Berichte, dass das Modell in 100 Sprachen trainiert ist und ein breites Aufgabenspektrum ausführt. Es wird bereits für 25 Funktionen und Produkte eingesetzt, darunter auch für den experimentellen Chatbot Bard des Unternehmens. Es ist in vier Größen erhältlich, von der kleinsten bis zur größten: Gecko, Otter, Bison und Einhorn.

Laut öffentlichen Angaben ist PaLM 2 leistungsfähiger als jedes bestehende Modell. LLM auf Facebook heißt LLaMA bekannt geben Im Februar wurde es auf 1,4 Billionen Token trainiert. Das letzte Mal, dass OpenAI das ChatGPT-Schulungsvolumen mit GPT-3 teilte, gab das Unternehmen an, in dieser Zeit 300 Milliarden Codes trainiert zu haben. OpenAI veröffentlichte GPT-4 im März und sagte, es zeige in mehreren professionellen Tests eine „Leistung auf menschlichem Niveau“.

LaMDA, LLM-Konversation, die Google Fuß Vor zwei Jahren wurde es zusammen mit Bard im Februar gefördert und auf 1,5 Billionen Token trainiert, wie aus den neuesten Dokumenten hervorgeht, die CNBC eingesehen hat.

Da neue KI-Anwendungen schnell den Mainstream erreichen, wächst auch die Debatte über die zugrunde liegende Technologie.

Mehdi Elmohamady, leitender Forschungswissenschaftler bei Google, Er trat im Februar zurück Über die mangelnde Transparenz des Unternehmens. Am Dienstag sagte Sam Altman, CEO von OpenAI, bei einer Anhörung des Justizunterausschusses für Datenschutz und Technologie des Senats aus und stimmte mit den Gesetzgebern darin überein, dass ein neues System für den Umgang mit KI erforderlich sei.

„Für eine so neue Technologie brauchen wir ein neues Framework“, sagte Altman. „Sicherlich tragen Unternehmen wie unseres eine große Verantwortung für die Werkzeuge, die wir der Welt zur Verfügung stellen.“

– Jordan Novette von CNBC hat zu diesem Bericht beigetragen.

Er schaut: Sam Altman, CEO von OpenAI, hat die Verwaltung der KI gefordert

„Webspezialist. Lebenslanger Zombie-Experte. Kaffee-Ninja. Hipster-freundlicher Analyst.“

More Stories

Die nächste 4K-Minidrohne von DJI passt in Ihre Handfläche

Leaks enthüllen den Namen und das Design des angeblichen PS5 Pro-Geräts

Apple führt mit dem neuesten iOS-Update die KI-Objektentfernung in Fotos ein