Für Weizenbaum war diese Tatsache laut einem MIT-Nachruf von 2008 ein Grund zur Sorge.Jene, die mit Elisa interagierten, waren bereit, ihr ihr Herz zu öffnen, obwohl sie wussten, dass es sich um ein Computerprogramm handelte. „Eliza zeigt nicht zuletzt, wie einfach es ist, die Illusion des Verstehens und damit vielleicht des Urteilens zu erzeugen und aufrechtzuerhalten „Er verdient Glaubwürdigkeit“, schrieb Weisenbaum 1966. „Da lauert eine gewisse Gefahr.“ Er verbrachte das Ende seiner Karriere damit, davor zu warnen, Maschinen zu viel Verantwortung zu übertragen, und wurde zu einem überzeugten philosophischen Kritiker der künstlichen Intelligenz.

Schon vorher war unsere komplexe Beziehung zu künstlicher Intelligenz und Maschinen in den Handlungen von Hollywood-Filmen wie „Her“ oder „Ex-Machina“ offensichtlich, ganz zu schweigen von den harmlosen Diskussionen mit Menschen, die darauf bestehen, Sprachassistenten „Danke“ zu sagen wie Alexa oder Siri.

In der Zwischenzeit warnen andere davor, dass die Technologie hinter KI-gestützten Chatbots begrenzter bleibt, als manche möchten. „Diese Technologien sind wirklich gut darin, Menschen vorzutäuschen, und sie sehen menschenähnlich aus, aber sie sind nicht tiefgründig“, sagte Gary Marcus, ein Forscher für künstliche Intelligenz und emeritierter Professor an der New York University. „Es ist eine Imitation, diese Systeme, aber es ist eine sehr oberflächliche Imitation. Sie verstehen nicht wirklich, wovon sie reden.“

Da sich diese Dienste jedoch in immer mehr Bereiche unseres Lebens ausbreiten und Unternehmen Schritte unternehmen, um diese Tools weiter anzupassen, können auch unsere Beziehungen zu ihnen immer komplexer werden.

Die Entwicklung von Chatbots

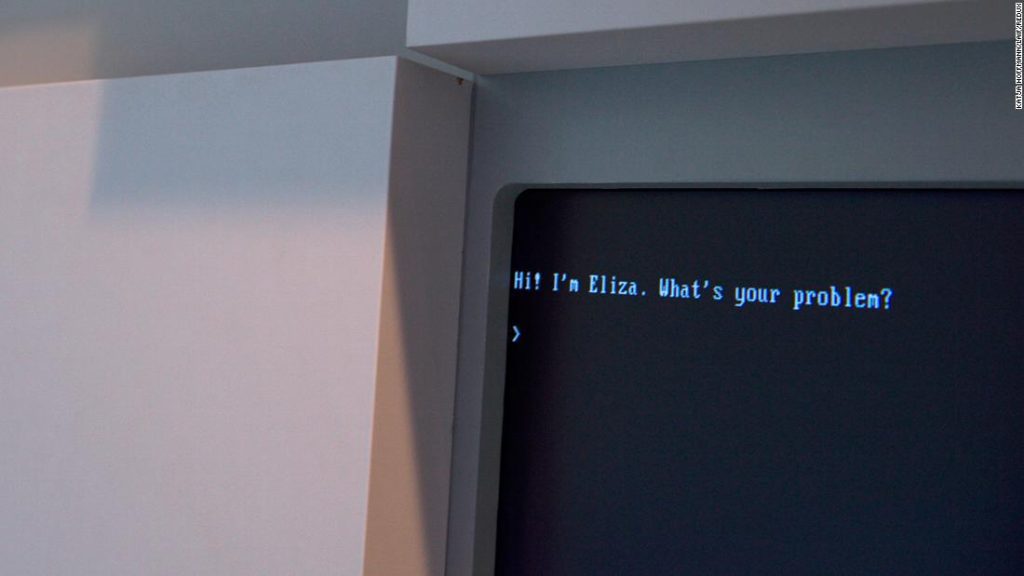

Sanjeev b. Khodanpour erinnert sich an ein Gespräch mit Eliza, als er die Schule abschloss. Trotz seiner historischen Bedeutung in der Technologiebranche habe es nicht lange gedauert, seine Grenzen zu erkennen.

sagte Khodanpour, ein Experte für die Anwendung theoretischer Informatikmethoden auf menschliche Sprachtechnologien und Professor an der Johns Hopkins University.

Aber in den Jahrzehnten seit diesen Tools hat es eine Abkehr von der Idee gegeben, „mit Computern zu sprechen“. Dies, „weil sich das Problem als sehr schwierig erwiesen hat“, sagte Khodanpour. Stattdessen habe sich der Fokus auf einen „zielorientierten Dialog“ verlagert, sagte er.

Um den Unterschied zu verstehen, denken Sie an die Gespräche, die Sie vielleicht gerade mit Alexa oder Siri führen. Normalerweise bitten Sie diese digitalen Assistenten, beim Kauf eines Tickets zu helfen, das Wetter zu überprüfen oder ein Lied zu spielen. Dies ist ein zielorientierter Dialog, der zum Hauptfokus akademischer und industrieller Forschung geworden ist, da Informatiker versucht haben, etwas Nützliches aus der Fähigkeit von Computern zu extrahieren, menschliche Sprache zu scannen.

Während sie eine ähnliche Technologie wie in früheren Social-Chat-Programmen verwendeten, sagte Khodanpour: „Sie können sie nicht wirklich Chatbots nennen. Sie können sie Sprachassistenten oder einfach digitale Assistenten nennen, die Ihnen bei bestimmten Aufgaben helfen.“

Er fügte hinzu, dass es in dieser Technologie jahrzehntelang „Ruhe“ gegeben habe, bis das Internet weit verbreitet sei. „Die großen Durchbrüche kamen wahrscheinlich in diesem Jahrtausend“, sagte Khodanpour. „Mit dem Aufkommen von Unternehmen, die erfolgreich eine Art computergestützten Agenten zur Durchführung von Routineaufgaben eingesetzt haben.“

„Die Leute regen sich immer auf, wenn ihre Taschen verloren gehen, und die menschlichen Kunden, mit denen sie zu tun haben, sind immer gestresst von all dieser Negativität, also sagten sie: ‚Lass es uns einem Computer geben’“, sagte Khodanpour. Sie können auf dem Computer schreien, was Sie wollen, alles, was Sie wissen wollen, ist: „Haben Sie Ihre Kartennummer, damit ich Ihnen sagen kann, wo Ihre Tasche ist? „

Zurück zu sozialen Chatprogrammen und sozialen Problemen

In den frühen 2000er Jahren begannen Forscher, die Entwicklung sozialer Chatbots zu überdenken, die eine längere Konversation mit Menschen führen könnten. Diese Chatbots, die oft mit großen Datenmengen aus dem Internet trainiert wurden, haben gelernt, sehr gute Simulationen der menschlichen Sprache zu sein – aber sie riskieren auch, einige der schlimmsten des Internets wiederzugeben.

„Je mehr Sie mit Tay sprechen, desto klüger werden Sie, sodass die Erfahrung für Sie persönlicher werden kann“, sagte Microsoft damals.

Diese Refrains werden von anderen Tech-Giganten wiederholt, die öffentliche Chatbots veröffentlicht haben, einschließlich Meta BlenderBot3, der Anfang dieses Monats veröffentlicht wurde. Der Meta-Chatbot hat fälschlicherweise behauptet, Donald Trump sei immer noch Präsident, und es gebe „sicherlich viele Beweise“ für Wahldiebstahl, neben anderen kontroversen Äußerungen.

BlenderBot3 behauptete auch, mehr als nur ein Bot zu sein.

Trotz all der Fortschritte, die seit Eliza gemacht wurden, und der riesigen Mengen an neuen Daten, um diese Sprachverarbeitungsprogramme zu trainieren, sagte Marcus, Professor der New York University: „Mir ist nicht klar, dass man wirklich einen zuverlässigen und sicheren Chatbot bauen kann. „

Auf der anderen Seite bleibt Khodanpur hinsichtlich seiner potenziellen Anwendungsfälle optimistisch. „Ich habe diese ganze Ansicht darüber, wie KI Menschen auf individueller Ebene stärken kann“, sagte er. „Stellen Sie sich vor, wenn mein Roboter alle wissenschaftlichen Artikel auf meinem Gebiet lesen könnte, müsste ich sie nicht alle lesen, ich würde einfach nachdenken, Fragen stellen und einen Dialog führen“, sagte er. „Mit anderen Worten, ich werde eine alternative Psyche haben, die über integrierte Superkräfte verfügt.“

„Webspezialist. Lebenslanger Zombie-Experte. Kaffee-Ninja. Hipster-freundlicher Analyst.“

More Stories

Die nächste 4K-Minidrohne von DJI passt in Ihre Handfläche

Leaks enthüllen den Namen und das Design des angeblichen PS5 Pro-Geräts

Apple führt mit dem neuesten iOS-Update die KI-Objektentfernung in Fotos ein