- Am Montag gab Apple auf der WWDC gekonnt bekannt, wie viel Arbeit an den neuesten KI- und maschinellen Lerntechnologien steckt.

- Im Gegensatz zu den meisten KI-gestützten Technologieunternehmen führt Apple modernste Verarbeitung auf seinen Geräten durch, anstatt sich auf die Cloud zu verlassen.

- Anstatt über KI-Modelle und -Technologien zu sprechen, bedeutet die Konzentration auf ein Apple-Produkt, dass es normalerweise nur neue Funktionen zur Schau stellt, die stillschweigend von der KI hinter den Kulissen ermöglicht werden.

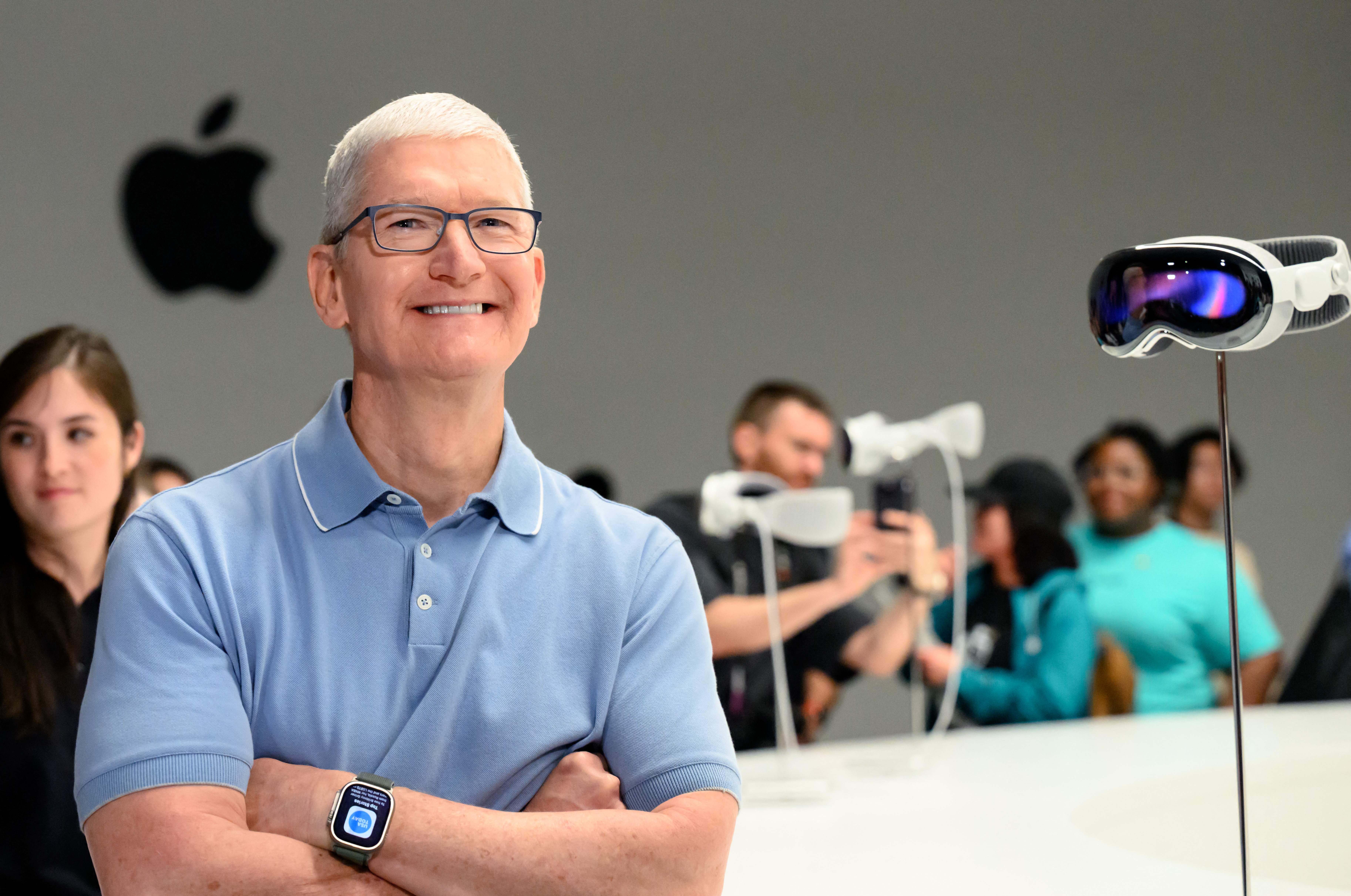

Apple Park ist vor der Worldwide Developers Conference (WWDC) am 5. Juni 2023 in Cupertino, Kalifornien, zu sehen.

Josh Adelson | AFP | Getty Images

Am Montag gab das Unternehmen während der jährlichen WWDC-Entwicklerkonferenz von Apple bekannt, wie viel Arbeit es an den neuesten KI- und maschinellen Lerntechnologien steckt.

Als Microsoft, Google und Start-ups wie OpenAI modernste Technologien für maschinelles Lernen wie Chatbots und generative KI einführten, schien Apple am Rande zu stehen.

Aber am Montag kündigte Apple mehrere wichtige KI-Funktionen an, darunter die iPhone-Autokorrektur, die auf Software für maschinelles Lernen basiert und ein Adaptersprachenmodell verwendet, die gleiche Technologie, die ChatGPT zugrunde liegt. Apple sagte, es werde sogar daraus lernen, wie der Benutzer Skripte und Typen ausführt, um sich zu verbessern.

Craig Federighi, Chief Software Officer von Apple, scherzte über die Tendenz von AutoCorrect, das unsinnige Wort „Ducken“ zu verwenden, um einen üblichen Schimpfwort zu ersetzen.

Die größte Neuigkeit am Montag war das coole neue Augmented-Reality-Headset Vision Pro, aber Apple hat trotzdem gezeigt, wie es funktioniert, und ist an den neuesten Entwicklungen in den Bereichen maschinelles Lernen und künstliche Intelligenz interessiert. ChatGPT von OpenAI hat bei seiner Einführung letztes Jahr zwar in zwei Monaten mehr als 100 Millionen Nutzer erreicht, aber Apple nutzt die Technologie nun, um eine Funktion zu verbessern, die täglich von einer Milliarde iPhone-Besitzern genutzt wird.

Im Gegensatz zu seinen Konkurrenten, die größere Modelle mit Serverfarmen, Supercomputern und Terabytes an Daten bauen, möchte Apple KI-Modelle auf seinen Geräten haben. Die neue Autokorrekturfunktion ist besonders beeindruckend, da sie auf dem iPhone funktioniert, während Modelle wie ChatGPT Hunderte von teuren GPUs erfordern, die im Tandem arbeiten.

KI auf dem Gerät umgeht viele der Datenschutzprobleme, mit denen cloudbasierte KI konfrontiert ist. Wenn ein Modell auf einem Telefon ausgeführt werden kann, muss Apple weniger Daten sammeln, um es auszuführen.

Es hängt auch eng damit zusammen, dass Apple sein Hardware-Portfolio kontrolliert, bis hin zu seinen Siliziumchips. Apple baut jedes Jahr neue KI-Schaltkreise und GPUs in seine Chips ein und seine Kontrolle über die Gesamtarchitektur ermöglicht es ihm, sich an Veränderungen und neue Technologien anzupassen.

Apple spricht nicht gern von „künstlicher Intelligenz“ – sie bevorzugen die akademische Bezeichnung „maschinelles Lernen“ oder reden einfach über den Vorteil, den die Technologie ermöglicht.

Einige der anderen führenden KI-Unternehmen haben Führungskräfte mit akademischem Hintergrund. Dies hat dazu geführt, dass Sie sich darauf konzentriert haben, Ihre Arbeit zu präsentieren, zu erklären, wie sie sich in Zukunft verbessern lässt, und sie zu dokumentieren, damit andere sie studieren und darauf aufbauen können.

Apple ist ein Produktunternehmen und seit Jahrzehnten sehr geheim. Anstatt über das spezifische KI-Modell, die Trainingsdaten oder mögliche Verbesserungen in der Zukunft zu sprechen, erwähnt Apple lediglich die Funktion und sagt, dass hinter den Kulissen großartige Technologie arbeitet.

Ein solches Beispiel am Montag ist eine Verbesserung der AirPods Pro, die die Geräuschunterdrückung automatisch deaktiviert, wenn ein Benutzer an einem Gespräch beteiligt ist. Apple hat es nicht als Funktion für maschinelles Lernen definiert, aber es ist schwer zu lösen und die Lösung basiert auf Modellen der künstlichen Intelligenz.

Eines der kühnsten Features, das am Montag angekündigt wurde, ist die neue Digital Persona-Funktion von Apple, die das Gesicht und den Körper eines Benutzers in 3D scannt und dann virtuell nachbilden kann, wie er aussieht, während er ein Headset per Videokonferenz mit anderen Personen führt. Vision Pro.

Apple erwähnte auch mehrere andere neue Funktionen, die die Fähigkeiten des Unternehmens im Bereich neuronaler Netze nutzten, beispielsweise die Möglichkeit, Felder zum Ausfüllen einer PDF-Datei auszuwählen.

Einer der größten Jubelrufe des Nachmittags in Cupertino war die maschinelle Lernfunktion, die es dem iPhone ermöglicht, Ihr Haustier – im Vergleich zu anderen Katzen oder Hunden – zu erkennen und alle Haustierfotos eines Benutzers in einem Ordner abzulegen.

„Webspezialist. Lebenslanger Zombie-Experte. Kaffee-Ninja. Hipster-freundlicher Analyst.“

More Stories

Die nächste 4K-Minidrohne von DJI passt in Ihre Handfläche

Leaks enthüllen den Namen und das Design des angeblichen PS5 Pro-Geräts

Apple führt mit dem neuesten iOS-Update die KI-Objektentfernung in Fotos ein